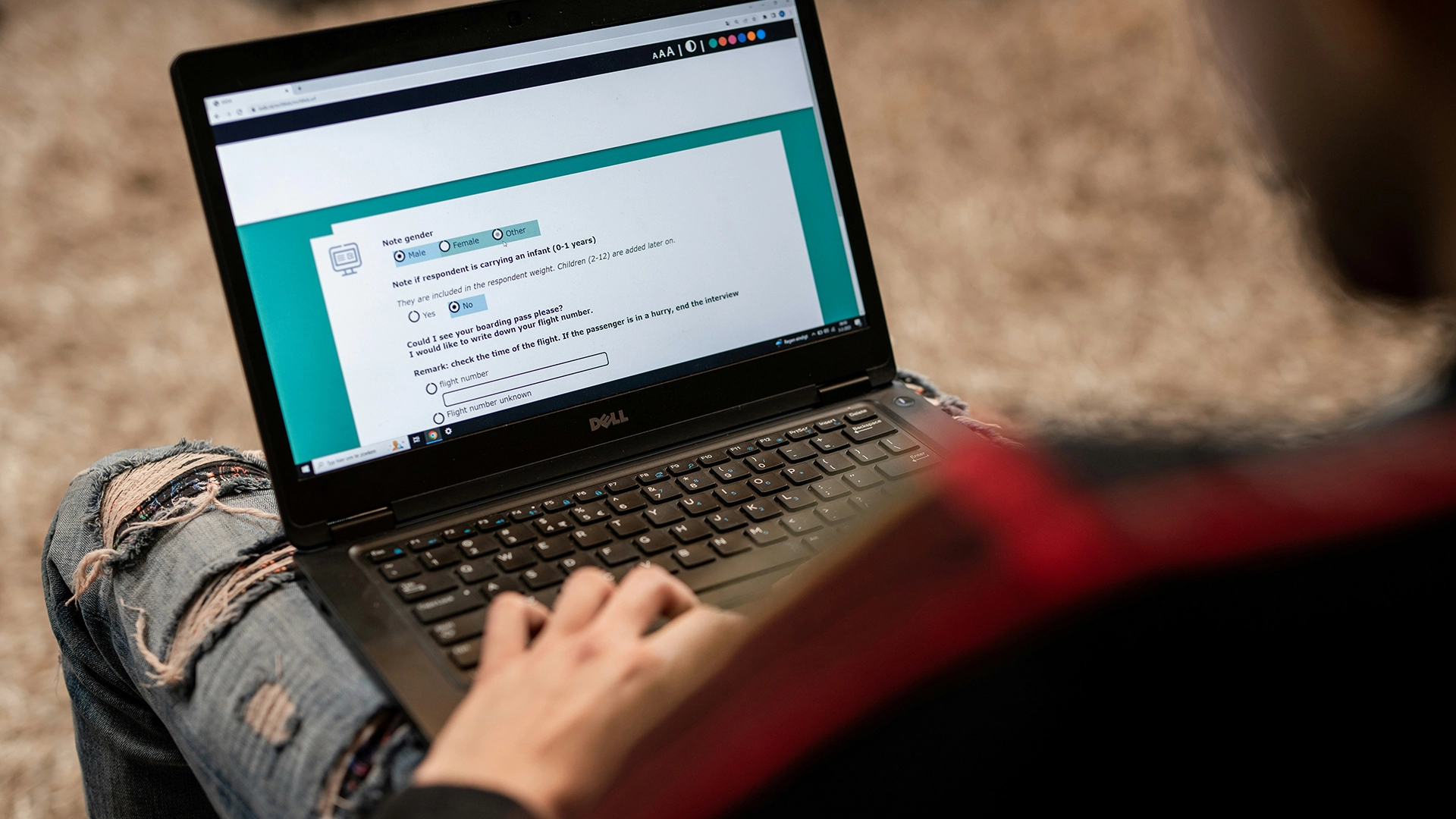

Image by ODISSEI, from Unsplash

온라인 설문조사 응답의 거의 절반이 AI로부터 나올 수 있다는 연구 결과 발견

이전에는 신뢰할 수 있는 인간 심리학 연구 방법으로 간주되던 온라인 행동 연구는 이제 참가자들이 챗봇과 같은 AI 도구를 사용해 응답을 생성함에 따라 주요한 문제에 직면하게 되었습니다.

시간이 부족하신가요? 여기에 간략한 사실들이 있습니다:

- 프로리픽 설문조사 참가자의 45%가 AI가 생성한 답변을 붙여넣었습니다.

- 연구자들은 챗봇 텍스트가 종종 “과도하게 장황하다”거나 “비인간적이다”라고 보였다고 밝혔습니다.

- 전문가들은 이 문제를 “LLM 오염”이라고 부르며, 이는 행동 연구의 타당성에 위협을 가하고 있습니다.

베를린에 위치한 막스 플랑크 인간 발전 연구소의 연구자들이 최근 조사를 통해 Prolific과 같은 플랫폼에서 설문 조사를 완료하도록 자원봉사자들에게 지불하는 문제가 얼마나 널리 퍼져 있는지를 살펴보았습니다.

“우리가 관찰한 발생률은 정말로 충격적이었습니다,”라고 주 연구원인 앤-마리 누스버거가 New Scientist (NS)에서 보도했습니다.

한 테스트에서 참가자의 45%가 챗봇이 생성한 내용을 자유 형식의 응답 상자에 붙여넣은 것으로 나타났습니다. 응답들은 종종 ‘과도하게 장황한’ 또는 ‘분명히 비인간적인’ 언어와 같은 특징을 보였습니다.

“올해 초에 수집한 데이터로 보아, 상당한 비율의 연구가 오염되어 있는 것 같습니다.” 누스버거가 NS에 말했습니다.

불량한 응답을 찾아내기 위해, 그녀의 팀은 숨겨진 함정을 도입했습니다. 기본 reCAPTCHA는 사용자의 0.2 퍼센트를 포착했고, 보다 고급 버전은 2.7 퍼센트를 잡아냈습니다. “헤이즐넛”이라는 단어를 요구하는 보이지 않는 텍스트 프롬프트는 1.6 퍼센트를 잡았고, 복사-붙여넣기를 금지하면서 추가로 4.7 퍼센트를 드러냈습니다.

이 문제는 이제 전문가들이 “LLM 오염”이라고 부르는 상태로 발전했으며, 이는 부정행위를 넘어선 범위입니다. 연구 결과는 세 가지 AI 개입 패턴을 드러냅니다: 부분 중재 (AI가 문구나 번역을 돕는 경우), 완전 위임 (AI가 전체 연구를 수행하는 경우), 그리고 Spillover (사람들이 AI의 존재를 예상하고 그에 따라 행동을 수정하는 경우).

“우리가 해야 할 일은 온라인 연구를 완전히 불신하는 것이 아니라, 반응하고 대응하는 것입니다.”라고 Nussberger가 말하며, 플랫폼들이 이 문제를 진지하게 받아들일 것을 요청했습니다. 이는 NS에 의해 보도되었습니다.

연구 윤리 컨설턴트인 맷 호지킨슨(Matt Hodgkinson)은 NS에 경고했습니다: “온라인 행동 연구의 무결성은 이미 도전받고 있습니다 […] 연구자들은 원격으로 인간 참여를 확인하는 방법을 공동으로 찾아내거나, 직접 대면하는 옛 방식으로 돌아가야 합니다.”

Prolific은 NS에 대한 코멘트를 거절했습니다.

이전 이야기

이전 이야기

최신 기사

최신 기사